Glosario PPyD

Especial | A | B | C | D | E | F | G | H | I | J | K | L | M | N | Ñ | O | P | Q | R | S | T | U | V | W | X | Y | Z | TODAS

C |

|---|

ConcurrenciaHabilidad de un algoritmo para ejecutar múltiples operaciones en un momento.

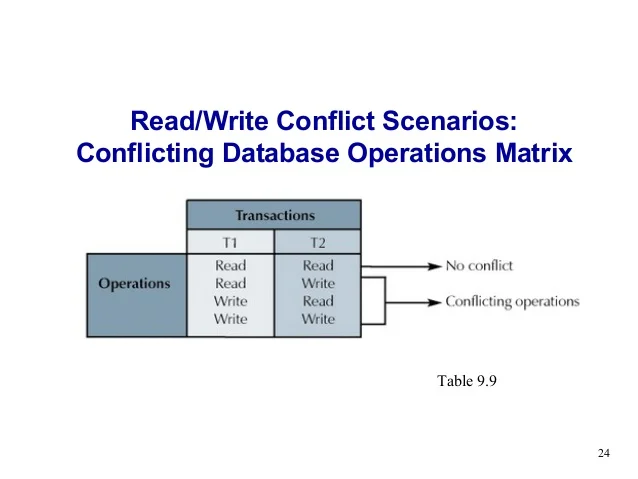

En la figura podemos observar distintas operaciones simultáneas a una base de datos, podemos ver como las operaciones que están en conflicto serán tratadas por la base de datos aplicando algún algoritmo de concurrencia,ej: 2PL( algoritmo de bloqueo). | |

Concurrencia AparenteEl número de procesos es mayor que el número de procesadores disponibles. Cada proceso avanza su ejecución intercalando con el resto. La concurrencia aparente describe la ilusión de que varias tareas están ejecutándose simultáneamente, aunque en realidad se están ejecutando de manera secuencial y alternada rápidamente. Esto se logra mediante técnicas el uso de hilos de ejecución en sistemas operativos que simulan la ejecución simultánea de múltiples procesos o tareas. | ||

Concurrencia RealCada proceso es ejecutado en un procesador. Es decir, el número de procesos es menor o igual que el número de procesadores disponibles. | |

Condiciones de BernsteinSupongamos un programa S, donde L(S) son lecturas y E(S) son escrituras dentro del código de S. Dos instrucciones de S, denominadas S1 y S2, pueden ser ejecutadas en un orden cualquiera, o en paralelo, si las tres condiciones siguientes se cumplen:

| ||